Le projet s'inscrit dans le cadre des initiatives de transformation numérique et d'optimisation des processus analytiques d’un client majeur opérant dans le secteur du commerce de détail.

Cette architecture catalyse l'innovation technologique et l'efficacité opérationnelle avec une adaptabilité et une scalabilité maximales.

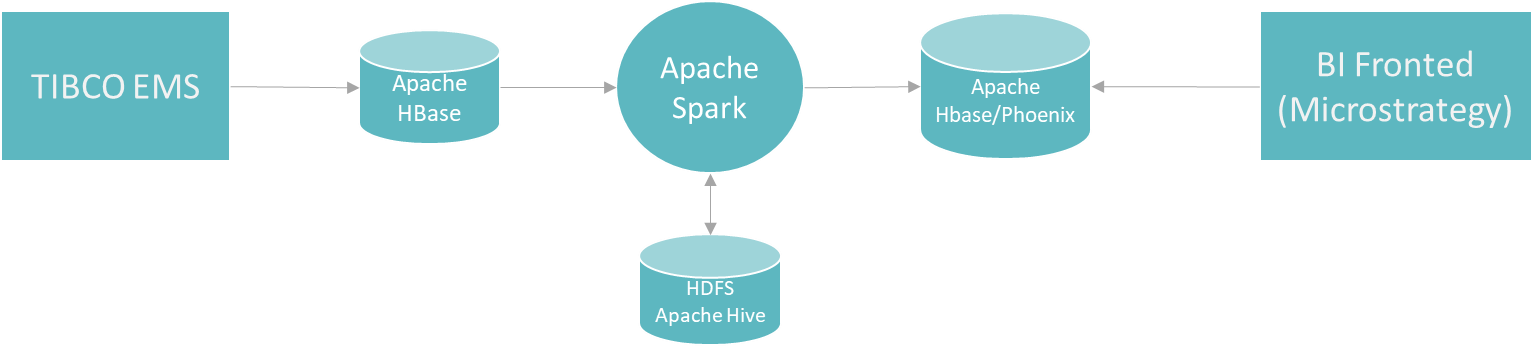

Apache Phoenix s'appuie sur HBase, une base de données NoSQL hautement performante, pour le stockage des données. Cette architecture garantit une gestion rapide et évolutive des grands volumes de données.

La couche d'analyse d'Apache Phoenix permet une exploration rapide des données et la génération de chiffres clés. Les tables dans HBase/Phoenix peuvent être pré-optimisées pour des modèles d'analyse spécifiques, similaires à la création d'indices dans les bases de données relationnelles, améliorant ainsi les performances des requêtes.

Les besoins futurs en reporting peuvent être satisfaits grâce à Spark, qui offre une solution performante pour générer de nouvelles tables d'analyse à partir des données brutes ou des couches intermédiaires. Cette approche assure une adaptabilité aux besoins évolutifs d'analyse.

MicroStrategy est utilisé comme interface principale pour l'analyse des reçus individuels et divers autres cas d'utilisation. Déjà bien établi chez le client, il s'intègre aux données analytiques via Apache Phoenix, facilitant son utilisation comme un outil BI central.

L'intégration avec Hadoop via Apache Phoenix offre des avantages clés grâce à l'interface SQL standard accessible via JDBC. Phoenix masque la complexité des mécanismes d'accès d'HBase, rendant les données Hadoop facilement accessibles aux systèmes externes et simplifiant leur exploitation grâce à des normes familières (SQL et JDBC).

L'intégration de composants Hadoop améliore les fonctionnalités de la plateforme existante tout en offrant une scalabilité horizontale rentable, adaptée à l'évolution des volumes de données et des analyses.

Les nouveaux systèmes utilisent des interfaces standard telles que SQL et JDBC, permettant une intégration fluide. Cette flexibilité aide à choisir entre Hadoop et l'infrastructure actuelle selon les besoins spécifiques.

L'intérêt pour l'analyse en temps réel ouvre la voie à des projets tels que des tableaux de bord en quasi temps réel, en combinant des frameworks comme Apache Nifi avec l'écosystème Hadoop.